Definition: Real-time Rendering bezeichnet die Fähigkeit eines Computersystems, 3D-Grafiken sofort zu berechnen und darzustellen, während Nutzer mit ihnen interagieren, typischerweise mit mindestens 30-60 Bildern pro Sekunde.

Im Gegensatz zu Offline-Rendering, bei dem einzelne hochqualitative Bilder oder Videos über Stunden oder Tage berechnet werden, muss Real-time Rendering jedes Bild in Millisekunden erzeugen. Dies ermöglicht unmittelbare Reaktionen auf Nutzereingaben – Kamerarotation, Zoom, Konfigurationsänderungen – ohne wahrnehmbare Verzögerungen.

Für B2B-Unternehmen im Maschinenbau bedeutet Real-time Rendering: Kunden können Produkte interaktiv erkunden, Optionen in Echtzeit wechseln und Maschinen aus allen Blickwinkeln betrachten – auf Webseiten, in AR-Apps oder VR-Umgebungen.

Englisch: Real-time Rendering Deutsch: Echtzeit-Rendering

Grundlagen des Real-time Rendering

Frame-basierte Darstellung

Real-time Rendering funktioniert frame-basiert: Die GPU (Graphics Processing Unit) berechnet kontinuierlich einzelne Bilder (Frames) und zeigt diese auf dem Bildschirm an. Bei 60 FPS (Frames per Second) hat die GPU nur ~16 Millisekunden Zeit pro Frame – inklusive aller Berechnungen: Geometrie-Transformation, Beleuchtung, Texturen, Schatten, Post-Processing.

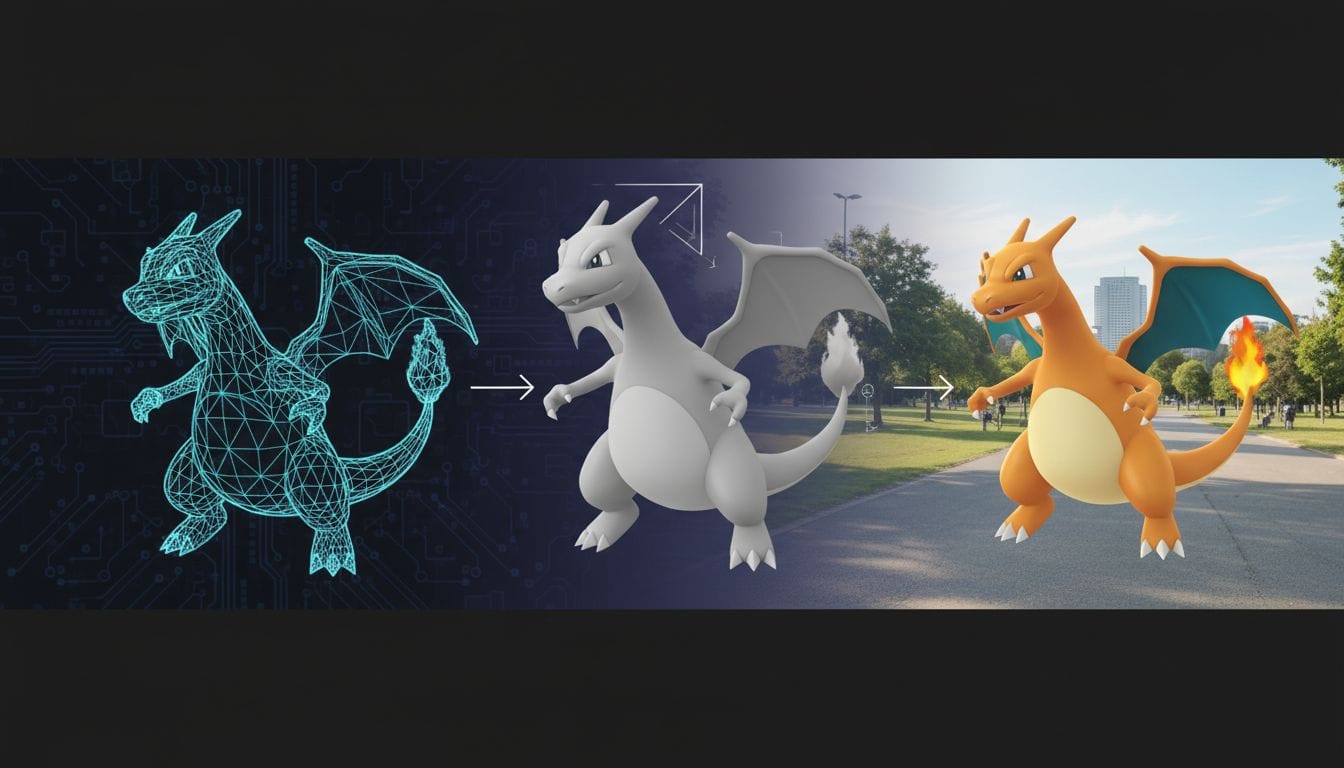

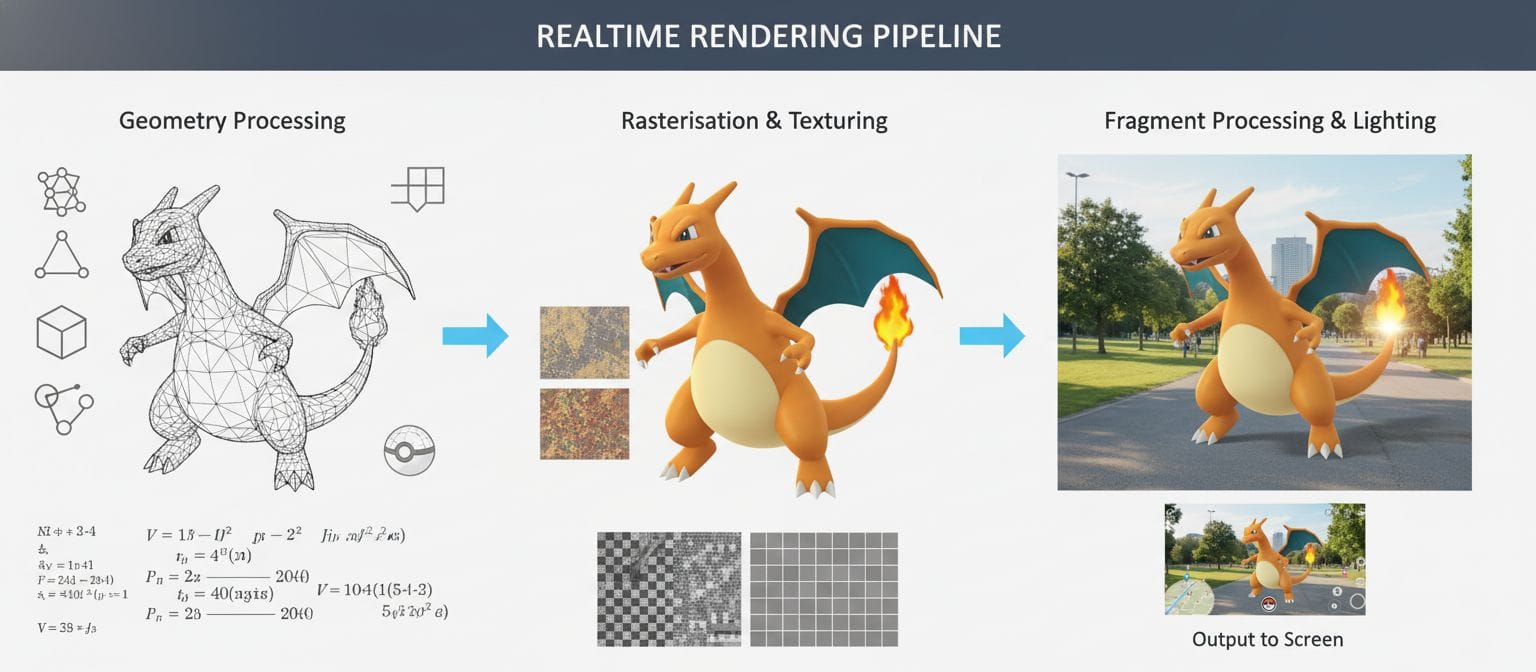

Die Rendering-Pipeline

Jeder Frame durchläuft eine standardisierte Pipeline:

- Application Stage: CPU bereitet Szene vor (welche Objekte sichtbar, welche Transformationen)

- Geometry Processing: GPU transformiert 3D-Koordinaten in Bildschirm-Koordinaten

- Rasterization: Umwandlung von Geometrie in Pixel

- Pixel/Fragment Processing: Berechnung von Farbe, Beleuchtung, Texturen für jeden Pixel

- Output: Fertiges Bild wird auf Bildschirm ausgegeben

Optimierungen zielen darauf ab, in jeder Stage Zeit zu sparen ohne sichtbare Qualitätsverluste.

Warum ist Real-time Rendering schwierig?

Physikalisch korrekte Beleuchtung (wie bei Offline-Rendering in Filmen) ist extrem rechenintensiv. Real-time Rendering nutzt Approximationen und Tricks, um ähnliche Ergebnisse in Bruchteilen der Zeit zu erreichen: - Vorberechnete Schatten-Maps statt Ray-Tracing - Level of Detail (LOD) – weniger Polygone für entfernte Objekte - Occlusion Culling – nicht sichtbare Objekte werden nicht gerendert - Textur-Baking – komplexe Beleuchtung wird in Texturen “eingebacken”

Rendering-Techniken im Vergleich

Rasterization (Klassisch)

Standard-Technik für Real-time Rendering seit Jahrzehnten. Geometrie wird in Dreiecke zerlegt, diese werden in Pixel umgewandelt. Sehr schnell, aber Einschränkungen bei Beleuchtung (nur direkte Beleuchtung, keine korrekten Reflexionen).

Vorteile: - Extrem schnell (millionen Polygone pro Frame möglich) - Breite Hardware-Unterstützung - Vorhersagbare Performance

Nachteile: - Schwierig für realistische Reflexionen und globale Beleuchtung - Schatten benötigen separate Berechnungen (Shadow Maps)

Ray-Tracing (Modern)

Simuliert physikalisch korrekt, wie Lichtstrahlen durch Szene wandern. Ermöglicht perfekte Reflexionen, Brechungen, weiche Schatten. Lange Zeit nur für Offline-Rendering praktikabel.

Real-time Ray-Tracing seit ~2018 möglich durch: - Spezialisierte Hardware (RTX-Kerne in modernen GPUs) - Hybrid-Ansätze (Rasterization für Basis, Ray-Tracing für Effekte) - Denoising-Algorithmen (weniger Strahlen nötig)

Vorteile: - Photorealistischere Darstellung - Korrekte Reflexionen und globale Beleuchtung - Weniger Tricks/Workarounds nötig

Nachteile: - Benötigt moderne, teure Hardware - Noch nicht auf allen Geräten verfügbar (Smartphones, ältere PCs) - Performance-Overhead

Für B2B-Produktvisualisierung: Hybrid-Ansatz empfohlen: Rasterization als Basis (breite Kompatibilität), optional Ray-Tracing für Premium-Erlebnis auf High-End-Hardware.

Real-time Rendering für B2B und Maschinenbau

Interaktive Produktkonfiguratoren

Kunden wählen Optionen (Farbe, Ausstattung, Module) und sehen sofort das Ergebnis. Real-time Rendering ermöglicht unmittelbares visuelles Feedback ohne Wartezeiten. Verkaufszyklus verkürzt sich, da Kunden Produkt besser verstehen.

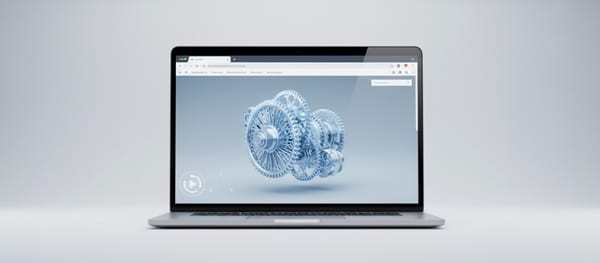

Web-basierte 3D-Viewer

Maschinen werden auf Webseiten in 3D dargestellt. Besucher können rotieren, zoomen, Animationen starten. Modernes WebGL/WebGPU ermöglicht Real-time Rendering direkt im Browser ohne Plugins. Wichtig: Performance-Optimierung für breite Geräte-Basis (Desktop, Tablet, Smartphone).

Virtual Reality Präsentationen

VR benötigt besonders hohes Real-time Rendering: 90-120 FPS für flüssige Bewegung ohne Motion Sickness, stereoskopisches Rendering (zwei Bilder gleichzeitig), niedrige Latenz (<20ms). VR-Anwendungen zeigen Maschinen in Lebensgröße, ermöglichen virtuelle Begehungen.

Augmented Reality Anwendungen

AR auf Smartphones benötigt Real-time Rendering mit zusätzlichen Herausforderungen: Kamera-Feed einblenden, Tracking berechnen, virtuelle Objekte perspektivisch korrekt einbetten – alles in Echtzeit auf mobiler Hardware. Performance-Budget noch enger als Desktop.

Schulung und Training

Interaktive Trainings-Szenarien mit Real-time Rendering ermöglichen Wiederholung beliebiger Situationen. Bediener lernen Maschinensteuerung in sicherer Umgebung. Sofortiges Feedback auf Aktionen durch Echtzeit-Visualisierung.

Virtuelle Messen und Showrooms

Digitale Messestände zeigen gesamtes Produktportfolio in 3D. Besucher erkunden eigenständig, wechseln zwischen Modellen, konfigurieren live. Real-time Rendering ermöglicht flüssige Navigation auch bei komplexen Szenen.

Performance-Optimierung für komplexe Maschinen

Polygon-Reduktion und LOD

CAD-Modelle haben oft Millionen Polygone – zu viel für Real-time Rendering. Optimierungstechniken:

- Polygon-Reduktion: Reduzierung auf 50.000-500.000 Polygone je nach Zielplattform

- Level of Detail (LOD): Mehrere Versionen des Modells mit unterschiedlicher Komplexität. Entfernte Objekte nutzen niedrigere LODs

- Imposters: Sehr entfernte Objekte werden durch Bilder ersetzt

Textur-Optimierung

Hochauflösende Texturen (4K, 8K aus CAD) sind zu groß für Real-time Rendering:

- Textur-Kompression: Reduzierung der Dateigröße ohne sichtbaren Qualitätsverlust

- Mipmaps: Vorberechnete verkleinerte Texturen für entfernte Objekte

- Texture Atlases: Mehrere Texturen in einer Datei kombinieren (weniger Drawcalls)

Material-Baking

Komplexe Materialien und Beleuchtung werden “eingebacken” in Texturen:

- Normal Maps: Simulieren Details ohne zusätzliche Polygone

- Ambient Occlusion: Vorberechnete Schatten in Vertiefungen

- Lightmaps: Statische Beleuchtung vorberechnet

Culling-Techniken

Nur sichtbare Objekte rendern:

- Frustum Culling: Objekte außerhalb Kamera-Sichtfeld ignorieren

- Occlusion Culling: Durch andere Objekte verdeckte Teile nicht rendern

- Distance Culling: Sehr weit entfernte Objekte ausblenden

Web-basiertes vs. Native Rendering

Web-basiert (WebGL/WebGPU)

Vorteile: - Keine Installation nötig (Browser genügt) - Plattformübergreifend (Windows, Mac, Linux, Mobile) - Einfache Verteilung (URL teilen) - Updates zentral

Nachteile: - Geringere Performance als native Apps - Browser-Unterschiede und Limitierungen - Eingeschränkter Hardware-Zugriff

Best für: Produkt-Viewer auf Webseiten, Marketing, erste Kundenkontakte

Native Apps (Unity, Unreal, Custom)

Vorteile: - Maximale Performance (voller Hardware-Zugriff) - Erweiterte Features (Ray-Tracing, Compute Shaders) - Offline-Fähigkeit - Tiefe Integration mit OS

Nachteile: - Installation erforderlich - Plattform-spezifische Builds (Windows, Mac, iOS, Android) - Updates erfordern Neuinstallation

Best für: VR-Anwendungen, AR-Apps, Konfiguratoren mit höchsten Qualitätsansprüchen

Hybrid-Ansatz: Viele B2B-Unternehmen kombinieren beide: Web-Viewer für Marketing/erste Kontakte, native Apps für Vertrieb und VR-Demos.

Hardware-Anforderungen

Desktop/Workstation

- Einstieg: Integrierte Grafik (Intel Xe, AMD Radeon) – einfache Modelle, niedrige Qualität

- Mittelklasse: Dedizierte GPU (NVIDIA GTX/RTX 3060, AMD RX 6600) – komplexe Maschinen, mittlere Qualität

- High-End: Workstation GPU (NVIDIA RTX A4000+) – sehr komplexe Szenen, höchste Qualität, Ray-Tracing

Mobile (Tablets, Smartphones)

- iOS: A12-Chip oder neuer für solides AR, A14+ für komplexe Szenen

- Android: Mittelklasse mit Adreno/Mali GPU, High-End für beste Performance

- Herausforderung: Große Performance-Varianz zwischen Geräten

Web-Browser

Performance abhängig von: - Browser-Engine (Chrome/Edge schneller als Safari für WebGL) - Hardware-Unterstützung für WebGPU (ab 2024 verfügbar) - Geräteklasse (Desktop > Tablet > Smartphone)

Häufig gestellte Fragen (FAQ)

Was ist der Unterschied zwischen Real-time und Offline-Rendering?

Real-time Rendering erzeugt Bilder sofort (30-60+ FPS) während der Interaktion, nutzt Approximationen für Geschwindigkeit. Offline-Rendering (z.B. für Marketing-Videos) berechnet jedes Bild über Minuten/Stunden, nutzt physikalisch korrekte Simulation für maximale Qualität. Vergleich: Real-time zeigt interaktive 3D-Modelle auf Webseiten, Offline erzeugt photorealistische Produktvideos. Für B2B beide relevant: Real-time für Konfiguratoren/Web, Offline für Marketingmaterial.

Wie viele Polygone kann Real-time Rendering darstellen?

Abhängig von Zielplattform: Desktop: 1-5 Millionen Polygone pro Frame bei 60 FPS (moderne GPU). Web-Browser: 100.000-500.000 Polygone empfohlen für breite Kompatibilität. Mobile AR: 50.000-200.000 Polygone je nach Gerät. VR: 500.000-2 Millionen (doppelt berechnet für Stereo). CAD-Modelle mit Millionen Polygonen müssen optimiert werden: Polygon-Reduktion, LOD, Instancing. Best Practice: Mehrere LOD-Stufen bereitstellen, automatisch nach Hardware-Fähigkeit wählen.

Können CAD-Modelle direkt für Real-time Rendering genutzt werden?

Nein, CAD-Modelle sind für Präzision optimiert (exakte Geometrie, NURBS-Flächen), nicht für Real-time Performance. Konvertierung nötig: 1) Tesselierung (NURBS → Polygone), 2) Polygon-Reduktion (z.B. 5 Mio → 200.000), 3) Textur-Baking (Materialien → Bilder), 4) LOD-Generierung (mehrere Detailstufen), 5) Textur-Kompression. Moderne Pipelines automatisieren dies. Einmal konvertiert, funktionieren Modelle für Web, AR, VR, Kiosk-Systeme.

Ist Real-time Ray-Tracing für B2B-Anwendungen sinnvoll?

Abhängig von Zielgruppe und Anwendung. Pro: Photorealistischere Darstellung erhöht Produktverständnis, perfekte Reflexionen bei glänzenden Maschinen, professionellerer Eindruck. Contra: Benötigt moderne Hardware (RTX 2000+ oder RX 6000+), nicht auf mobilen Geräten verfügbar, höhere Entwicklungskosten. Empfehlung: Hybrid-Ansatz – Rasterization als Baseline für breite Reichweite, optionales Ray-Tracing für High-End-Demos auf Messen oder bei Premium-Kunden. Nicht kritisch für Funktionsverständnis, aber wertvoll für emotionale Wirkung.

Welche Framerate ist für B2B-Anwendungen nötig?

30 FPS: Minimum für flüssige Darstellung, ausreichend für Web-Viewer mit einfacher Interaktion. 60 FPS: Empfohlen für Desktop-Anwendungen, glattere Bewegung, besseres Erlebnis. 90-120 FPS: Notwendig für VR (Motion Sickness vermeiden), höhere Immersion. Wichtiger als absolute Framerate: Konsistenz. Schwankende Framerates (30-60-30) wirken störender als konstante 30 FPS. Best Practice: Performance-Budget definieren, Qualität automatisch anpassen (adaptive Quality) für konsistente Framerates über verschiedene Hardware.

Branchenstandards und Technologien

WebGL 2.0 Web-Standard für 3D-Grafik im Browser, basiert auf OpenGL ES 3.0. Breite Unterstützung in allen modernen Browsern. Quelle: https://www.khronos.org/webgl/

WebGPU Nächste Generation Web-3D-API mit besserer Performance und modernen Features. Verfügbar ab 2024 in Chrome/Edge. Quelle: https://www.w3.org/TR/webgpu/

OpenGL / OpenGL ES Etablierte plattformübergreifende 3D-Grafik-API für Desktop und Mobile. Quelle: https://www.opengl.org/

Vulkan Moderne Low-Level-Grafik-API für maximale Performance auf Desktop, Mobile und VR. Quelle: https://www.vulkan.org/

DirectX 12 Microsofts High-Performance-Grafik-API für Windows und Xbox, unterstützt Ray-Tracing. Quelle: https://docs.microsoft.com/en-us/windows/win32/direct3d12/

glTF 2.0 Standard-3D-Format für Web und Real-time Anwendungen mit PBR-Material-Support. Quelle: https://www.khronos.org/gltf/

Verwandte Themen

3D-Technologien: - 3D-Modell – Digitale 3D-Repräsentation - Polygon-Reduktion – Optimierung für Performance - Level of Detail (LOD) – Performance-Management - Textur-Baking – Vorberechnung komplexer Effekte - PBR Materials – Physically Based Rendering

Rendering-Techniken: - Rasterization – Klassisches Real-time Rendering - Ray-Tracing – Physikalisch korrektes Rendering - Global Illumination – Indirekte Beleuchtung - Shadow Mapping – Schatten in Echtzeit - Ambient Occlusion – Vertiefungs-Schatten

Plattformen: - WebGL – Browser-3D-Grafik - WebGPU – Nächste Generation Web-3D - ARKit – iOS Real-time AR - ARCore – Android Real-time AR - Unity – Game Engine für Real-time Anwendungen - Unreal Engine – High-End Real-time Rendering

Immersive Technologien: - Virtual Reality (VR) – VR benötigt hohes Real-time Rendering - Augmented Reality (AR) – Mobile Real-time Rendering - Extended Reality (XR) – Überbegriff für AR/VR - Stereoscopic Rendering – Doppelte Berechnung für 3D-Effekt

Hardware: - GPU (Graphics Processing Unit) – Herzstück des Real-time Rendering - CUDA / Compute Shaders – GPU-Programmierung - RTX / Ray-Tracing Cores – Hardware-beschleunigtes Ray-Tracing

Anwendungsgebiete: - Product Visualization – 3D-Produktpräsentation - Product Configurators – Interaktive Konfiguration - 3D Web Viewer – Browser-basierte 3D-Ansicht - VR Training – Schulung in Echtzeit-3D - AR Visualization – Mobile 3D-Darstellung